Вызовы и проблемы при использовании Big Data в оценочной деятельности и пути их преодоления

Применение Big Data в оценочной деятельности открывает новые возможности для получения ценной информации и принятия обоснованных решений. Однако, вместе с этим, появляются и некоторые вызовы, и проблемы. В данной статье мы рассмотрим основные проблемы, связанные с использованием Big Data в оценочной деятельности, и предложим пути их преодоления с помощью эффективных стратегий и инструментов.

Качество данных

Одной из основных проблем при работе с Big Data является качество данных. Большие объемы данных могут содержать ошибки, пропуски, неоднородные форматы и другие несоответствия, что может исказить результаты оценки. Для преодоления этой проблемы рекомендуется:

- Установить систему контроля качества данных: Создайте процедуры и стандарты для проверки и очистки данных перед их использованием. Используйте автоматизированные методы, такие как алгоритмы обнаружения выбросов и дубликатов, для выявления и исправления ошибок.

- Использовать методы заполнения пропущенных значений: Если данные содержат пропуски, примените соответствующие методы заполнения пропущенных значений, такие как интерполяция или применение статистических моделей.

Хранение и обработка данных

Еще одной проблемой является хранение и обработка огромных объемов Big Data. Обработка данных может потребовать значительных вычислительных мощностей и ресурсов. Для решения этой проблемы можно применить следующие стратегии:

- Распределенные системы хранения данных: Используйте распределенные системы хранения данных, такие как Hadoop Distributed File System (HDFS) или Amazon S3, которые позволяют эффективно хранить и обрабатывать большие объемы данных.

- Облачные вычисления: Воспользуйтесь возможностями облачных вычислений для обработки Big Data. Облачные платформы, такие как Amazon Web Services (AWS) и Microsoft Azure, предлагают гибкие и масштабируемые ресурсы для обработки данных.

Конфиденциальность и безопасность данных

С увеличением объемов данных возрастает и риск утечки или несанкционированного доступа к конфиденциальным данным. Для обеспечения безопасности и конфиденциальности данных рекомендуется:

- Применять меры шифрования данных: Шифруйте данные как в покое, так и во время передачи, чтобы обеспечить их конфиденциальность.

- Установить систему контроля доступа: Ограничьте доступ к данным только для авторизованных пользователей. Реализуйте многоуровневые системы аутентификации и авторизации.

- Соблюдать соответствие нормам и правилам: Соблюдайте соответствующие нормативные и законодательные требования по защите данных, такие как Общий регламент по защите данных (GDPR) в Европейском союзе.

Использование Big Data в оценочной деятельности представляет большие возможности, но также сопряжено с вызовами и проблемами. Качество данных, хранение и обработка данных, а также безопасность и конфиденциальность являются основными аспектами, которые требуют внимания и решения. С помощью правильных стратегий, таких как контроль качества данных, использование распределенных систем хранения данных и облачных вычислений, а также соблюдение мер безопасности и конфиденциальности, организации могут преодолеть эти проблемы и получить максимальную пользу от Big Data в своей оценочной деятельности.

Какие есть характеристики у Big Data?

Многофункциональные платформы анализа применимы именно для массивных данных, которые невозможно обработать вручную. Для правильного понимания терминологии необходимы знания о базовых характеристиках Big Data.

К ним относятся данные, которые соответствуют нескольким критериям:

- В классическом понимании имеют суточный объём свыше 150 Гб. Текущий обмен информацией всё чаще измеряется в терабайтах.

- Регулярное обновление и обработка онлайн. Логи о различных операциях непрерывно поступают в журнал.

- Информация неоднородна. Файлы могут иметь разные форматы, размеры. Могут быть оформлены в структуру или разрознены.

- Потоки информации отличаются изменчивостью, могут иметь пики загрузки, периодичность, зависимость от сезонов и других обстоятельств.

- Дата-файлы имеют разные степени значимости, которые алгоритм анализа должен определить и структурировать.

- Сохраняется возможность визуализации результатов анализа. Например, в автоматическом режиме нельзя перевести в наглядный формат неоцифрованную информацию.

- Достоверность, точность информации и допустимость способов её получения. Некорректные сведения приведут к аналитическим ошибкам.

Первые три параметра считаются базовыми. Остальные дорабатывались и дополнялись по мере развития технологии. Каждый пункт имеет англоязычное наименование с названием на букву «V», поэтому принцип определения соответствия данных категории Big Data называют «VVV» по количеству базовых характеристик. Остальные понятия для сохранения единства принципа также имеют заглавную «V».

Критерии, соответственно, называются:

- Volume;

- Velocity;

- Variety;

- Variability;

- Value;

- Visualization;

- Veracity.

Сервисы для работы с большими массивами данных учитывают эти характеристики и позволяют правильно распределять и обрабатывать информацию.

Популярные статьи

1

Расчет себестоимости

Расчет себестоимости – очень сложный процесс

Важно не только правильно обобщить все затраты. Надо..

17.03.2020

•

Ольга Воробьева

2

PEST-анализ: что это такое и как его провести на примерах

Стратегический менеджмент – это работа с неопределенностью во внутренней и, особенно, во вне…

23.08.2019

•

Евгения Чернова

3

Анализ финансовых результатов деятельности компании: пошаговый алгоритм

Анализ финансовых результатов деятельности предприятия дает понимание, насколько эффективно оно ра…

31.01.2020

•

Ольга Воробьева

4

Система 5S на производстве: секреты успешного внедрения

Термин «5S» стал популярен в 1980-х годах в производственном секторе Японии. В это время успехи ко…

22.07.2019

•

Ильнар Фархутдинов

Инструменты и технологии для обработки и анализа Big Data.

| Tool/Technology | Description | Use Case |

|---|---|---|

| Hadoop | Apache Hadoop is an open-source software framework used for distributed storage and processing of large datasets. | Using Hadoop, companies can store and process huge volumes of structured and unstructured data to gain valuable insights. |

| Spark | Apache Spark is a fast and general-purpose cluster computing system designed for big data processing and analytics. | Spark is commonly used to process and analyze large-scale datasets in real-time, making it ideal for streaming, machine learning, and interactive queries. |

| Kafka | Apache Kafka is a distributed streaming platform that allows you to publish and subscribe to streams of records in a fault-tolerant manner. | Kafka is widely used for building real-time data pipelines and streaming applications, enabling high-throughput and fault-tolerant processing of data. |

Смешение и интеграция данных

Что это. Работа с big data часто связана со сбором разнородных данных из разных источников. Чтобы работать с этими данными, их нужно собрать воедино. Просто загрузить их в одну базу нельзя — разные источники могут выдавать данные в разных форматах и с разными параметрами. Тут и поможет смешение и интеграция данных — процесс приведения разнородной информации к единому виду.

Как это работает. Чтобы использовать данные из разных источников, используют следующие методы:

- Приводят данные к единому формату: распознают текст с фотографий, конвертируют документы, переводят текст в цифры.

- Дополняют данные. Если есть два источника данных об одном объекте, информацию от первого источника дополняют данными от второго, чтобы получить более полную картину.

- Отсеивают избыточные данные: если какой-то источник собирает лишнюю информацию, недоступную для анализа, ее удаляют.

Зачем и где применяют. Смешение и интеграция данных нужны, если есть несколько разных источников данных, и нужно анализировать эти данные в комплексе.

Например, ваш магазин торгует офлайн, через маркетплейсы и просто через интернет. Чтобы получить полную информацию о продажах и спросе, надо собрать множество данных: кассовые чеки, товарные остатки на складе, интернет-заказы, заказы через маркетплейс и так далее. Все эти данные поступают из разных мест и обычно имеют разный формат. Чтобы работать с ними, их нужно привести к единому виду.

Традиционные методы интеграции данных в основном основаны на процессе ETL — извлечение, преобразование и загрузка. Данные получают из источников, очищают и загружают в хранилище. Специальные инструменты экосистемы больших данных от Hadoop до баз данных NoSQL также имеют собственный подход для извлечения, преобразования и загрузки данных.

Список литературы

- What is GPT-3 and why is it so powerful? | Towards Data Science | Towards Data ScienceURL: https://towardsdatascience.com/what-is-gpt-3-and-why-is-it-so-powerful-21ea1ba59811 (Дата обращения 30.08.2022).

- Gazeta Summaries | Kaggle URL: https://www.kaggle.com/datasets/phoenix120/gazeta-summaries

- Frank, K. Frank Kane’s Taming Big Data with Apache Spark and Python / Packt Publishing. Birmingham, 2017. -289 c.

- What is Apache Spark? The big data platform that crushed Hadoop | InfoWorld URL: https://www.infoworld.com/article/3236869/what-is-apache-spark-the-big-data-platform-that-crushed-hadoop.html (Дата обращения 31.08.2022).

Что такое Big Data?

Каждый вычислительный процесс оставляет цифровой след. Он выражен в журнале логов — текстовых файлов с информацией о пользователях и производительности сервера. Кроме того, в сеть загружается и пересылается огромное количество медиафайлов различных форматов. Большие объёмы такой информации невозможно обработать в Excel, для них недостаточно одного компьютера. Обработка требует значительных вычислительных мощностей.

Работа с объёмными файлами объединена в понятие Big Data. В общем понимании — это методы и инструменты обработки огромных пластов разнообразной оцифрованной информации. Термин появился в конце нулевых годов нового тысячелетия и описывал явление взрывного роста информационных потоков.

Мировая информационная база по приблизительным оценкам составляет 46 триллионов гигабайт.

Среди источников получения информации:

- всемирная сеть — сайты, социальные сети, различные веб-приложения, онлайн-игры и другое;

- корпоративные структуры — информационные базы, архивы операций и т.д;

- метрология и сотовая связь — показания непрерывной работы считывающих устройств, датчиков, базы мобильных операторов.

Большие данные могут быть представлены в разных формах:

В первые годы методы Big Data использовались в большей степени для научных исследований. Сейчас это перспективный инструмент развития бизнеса и построения маркетинговых стратегий. Главные вопросы работы с массивными данными — безопасный обмен и автоматизированный анализ.

Как правильно организовать работу с Big Data

– Каждая компания имеет собственные данных о потребителях (демографическик, возрастных характеристиках, их предпочтениях и пр.).

Анжела Федорченко

Управляющий директор Weborama Russia

Вопрос в том, умеет ли компания эффективно работать с этими массивами информации – анализировать их, чтобы выявить закономерности в поведении клиентов.

Один из подходов – выстраивание т.н. data-cтратегии компании. Она напрямую связана с обработкой больших массивов данных (Big Data), и, в целом, предполагает эффективный подход к управлению этой информацией.

Data-cтратегия – совокупность методов и алгоритмов работы с данными о клиентах, собранными через онлайн и офлайн-каналы. Таким образом, для выстраивания работы с Big Data необходимо определить:

- Какие данные у вас уже есть

- Систематизированы ли они

- Какие сотрудники отвечают за их сбор и обработк

Фото с сайта habrahabr.ru

Примеры вопросов, которые помогают определить – какие данные о клиентах у вас есть, и насколько они систематизированны:

1. Знаете ли вы, сколько клиентов приобрели, а сколько потеряли в прошлом году?

2. Знаете ли вы количество клиентов, которые приходят к вам с сайта?

3. Обладаете ли вы сведениями о том, чем интересуется ваш клиент?

4. Известно ли вам, какие сайты чаще всего посещают ваши клиенты?

5. Фиксируют ли ваши менеджеры по продажам все сведения в единой базе данных?

6. Коммуницируете ли вы с клиентами, которые уже совершили целевое для вас действие?

Фото с сайта habrahabr.ru

«Цифровой след» сотрудника

Еще одна интересная гипотеза – это отслеживание «цифрового

следа» сотрудника, оставленного при работе с различными массивами данных,

взаимодействии с коллегами, прочей рабочей активности. На его основе могут

выявляться поведенческие гипотезы, которые позволят повысить удобство

взаимодействия пользователя с системой, окружением (другими системами, коллегами).

Игровые механики

Внедрение в корпоративное окружение элементов игры может

стать инструментом анализа поведения пользователей, стимулирования правильного

использования функций системы и глубокого их изучения, следования технологиям компании

и повышения эффективности.

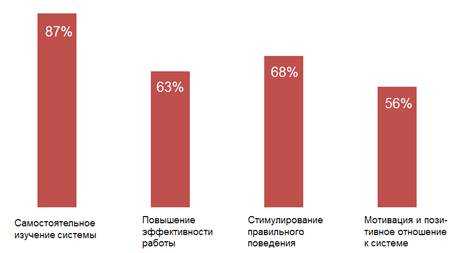

Элементы геймификации, внедренные в нашей компании,

подтвердили предположения о том, что новый подход становится стимулом для

сотрудников. Мы также выявили неожиданный факт, что основными участниками стали

не молодые сотрудники, а опытные, в возрасте за 30 лет, а также топ-менеджмент,

который нашел в игре новый элемент поиска активных сотрудников и оценки их эффективности.

Процент

сотрудников, отметивших конкретные плюсы геймификации

Социализация

Другим механизмом вовлечения может стать пересмотр

принципов работы сотрудников в корпоративных системах – от контента к

взаимодействую внутри рабочих групп. Формирование кругов по интересам (отделы,

крупные проекты, рабочие группы, профессиональные клубы и гильдии), получение

информации от коллег, формирование профессиональных дайджестов, внутренних

чатов – все это инструменты, которые могут помочь в вовлечении сотрудников и

повышении эффективности их работы.

Поиски закономерностей внутри работы плотно

взаимодействующих групп, быстрая передача им полномочий и информации,

закрепление результата, неформальная субординация, принципы хранения и

использования данных – все это становится возможным при включении социальных

механизмов в корпоративную среду.

И, если речь идет о крупной компании, имеющей в штате

тысячи сотрудников, накопление корпоративной статистики и ее анализ должны как

можно быстрее переходить от гипотез к реальным шагам.

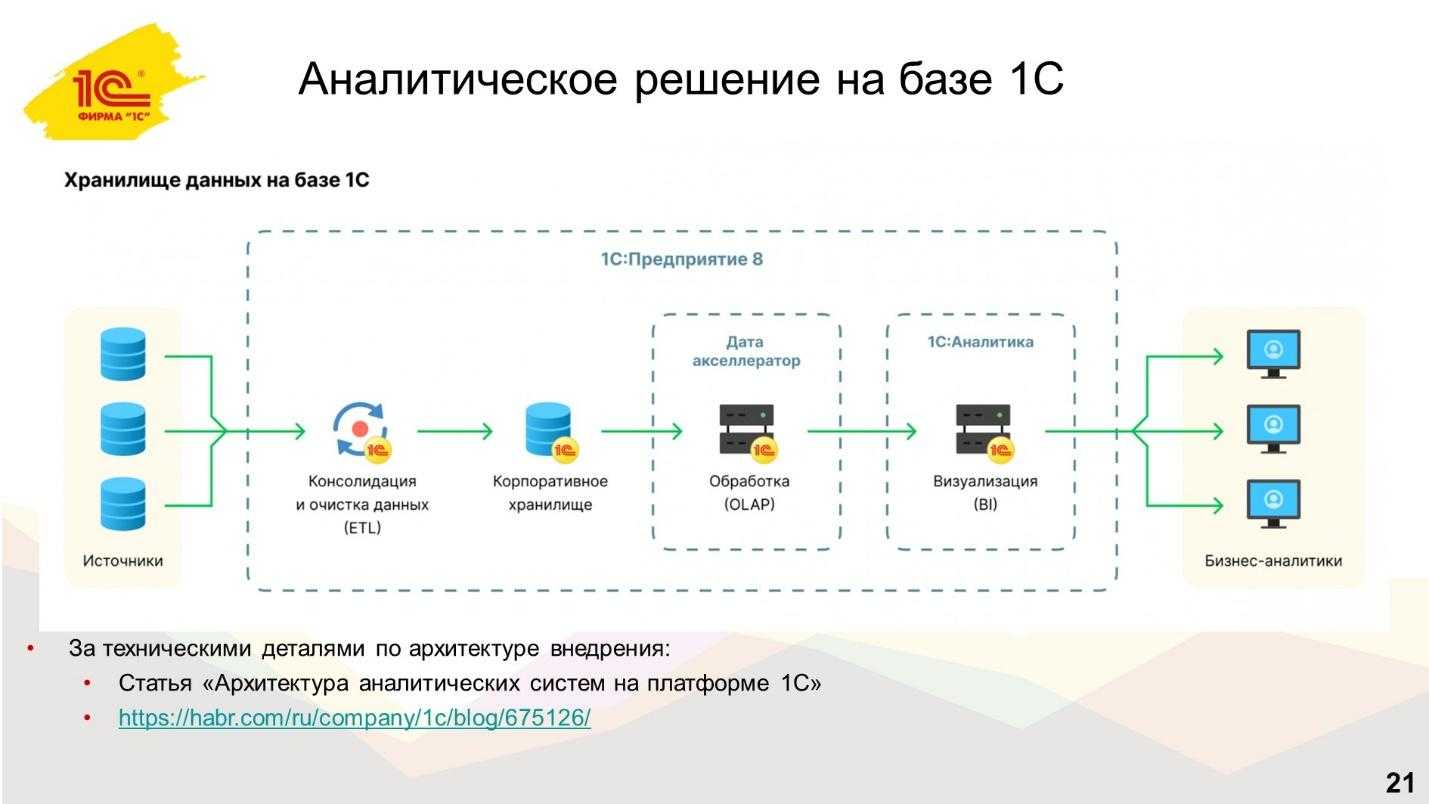

Архитектура и возможности 1С:Аналитики

Немного расскажу о схеме внедрения. Ближайшие два слайда будут немного технологическими, но они важны, чтобы понимать, за счет чего получается выигрыш при внедрении именно 1С:Аналитики.

Слайд отображает архитектуру аналитических систем на платформе 1С – подробнее об этом мы рассказывали в статье https://habr.com/ru/companies/1c/articles/675126/. Причем здесь две картинки в одной.

С одной стороны эта картинка показывает классическую схему архитектуры – то, как развертываются вообще все аналитические BI-системы. Классический подход заключается в том, что у вас есть четыре контура:

-

Есть контур консолидации и очистки данных – то, что называется ETL.

-

Дальше есть контур, где эта собранная, подготовленная информация кладется в корпоративное хранилище данных – это то место, где в базе лежит вся нужная вам информация, собранная со всей компании.

-

Дальше есть контур OLAP-сервера, который обеспечивает быструю работу аналитических отчетов. Потому что, если вы запустите аналитические отчеты на обыкновенной СУБД, они у вас вряд ли будут быстро работать. Скорее всего, они будут работать медленно. Чтобы аналитические отчеты работали быстро, в режиме реального времени, нужен контур с OLAP-сервером.

-

И потом всей этой системе нужен красивый, удобный, понятный интерфейс, чтобы нарисовать отчет и покрутить данные – то, что называется BI Business Intelligence.

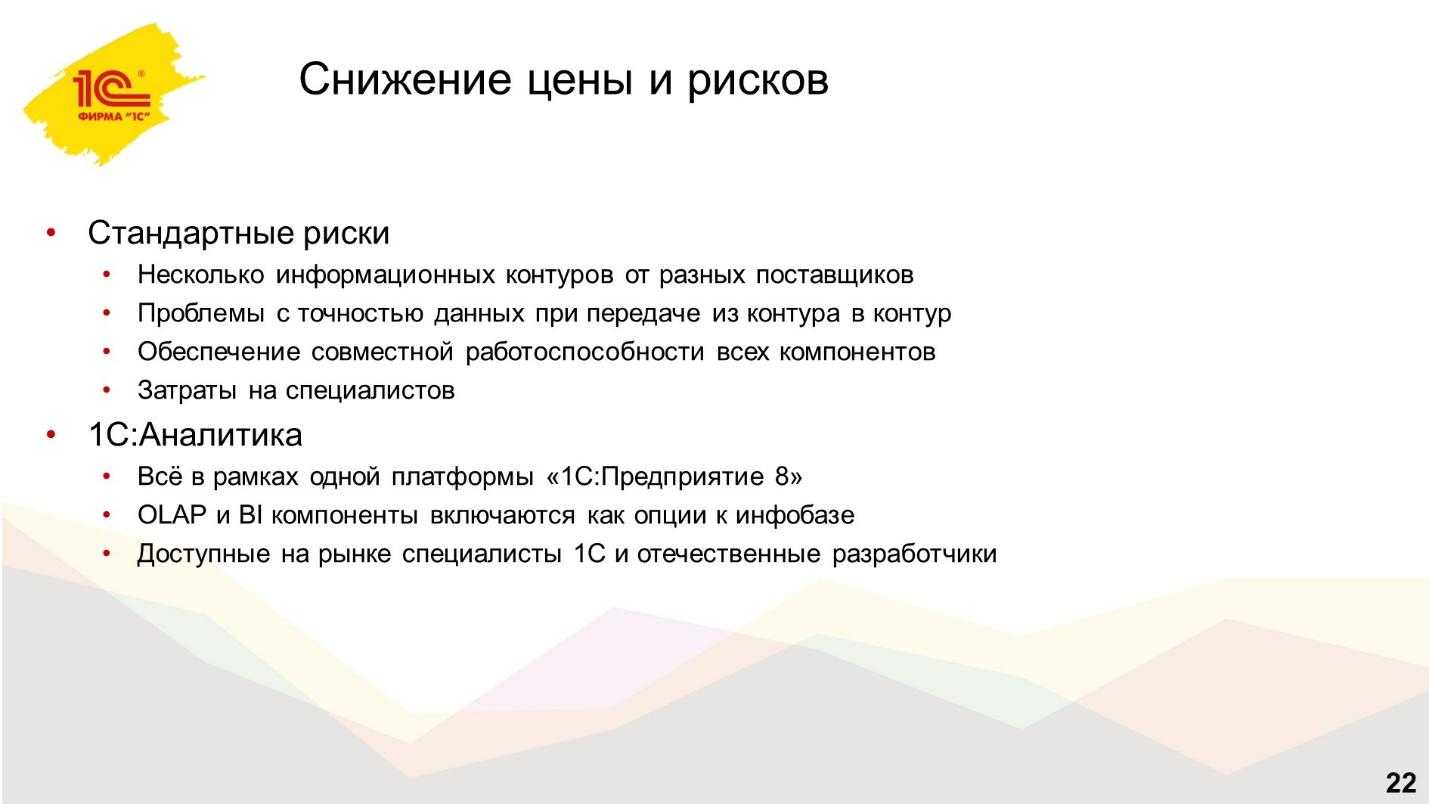

У классического подхода есть ряд проблем, которые мы в 1С попытались изменить:

-

На практике это обычно 4 разные системы, между которыми приходится передавать данные, и сильно беспокоиться, не исказились ли данные при передаче с одного уровня на другой.

-

Настройки безопасности – нет ли в каком-то контуре дополнительной дыры, потому что когда вы выносите данные из одной системы в другую, всегда нужно думать, не стало ли где-то хуже.

-

Это оплата лицензии на каждый уровень, потому что часто это разные продукты – вы разворачиваете 4 информационных контура.

-

И я уже не говорю о том, что нужны специалисты, чтобы это внедрить, и потом нужно специалисты, чтобы это обслуживать.

Именно в этих проблемах – главная причина того, что несмотря на то, что всем нужны аналитические системы, на практике полноценное внедрение BI-системы бывает достаточно редко. Это высокорисковое и высокозатратное занятие.

Главное, что изменила фирма «1С» – мы все эти компоненты сделали частью единой платформы 1С:Предприятия.

В рамках одной информационной базы вы можете использовать возможности платформы, чтобы:

Консолидировать данные, их очищать, собирать и класть в информационную базу.

Сама информационная база у вас становится хранилищем данных, куда может стекаться вся эта информация со всей фирмы

Я думаю, вы помните, что такое распределенная информационная база, и вас это с точки зрения техники уже не удивляет.

Но важно, что в рамках платформы есть компонент Дата акселератор, выступающий как настоящий OLAP-сервер, который позволяет работать с аналитическими отчетами в режиме реального времени.

И таким же родным компонентом внутри платформы является 1С:Аналитика, которая подключается, внедряется и добавляет внутрь платформы нужный вам красивый интерфейс.

За счет того, что у вас единый контур:

-

не нужно ничего никуда выгружать;

-

вы в рамках одной информационной базы включаете нужные опции, настраиваете и получаете единый сквозной работающий механизм, не тратя много лишних денег на какие-то дополнительные лицензии, не перетаскивая данные, не вынимая их никуда из платформы;

-

и самое главное, что для работы со всем этим требуется обычный специалист по 1С – я думаю, вы знаете, где таких специалистов найти.

Хочу привести хороший пример из жизни: как-то на одной конференции ко мне подошел человек с просьбой привести сравнение 1С:Аналитики с Power BI. Я уже приготовился прочесть лекцию, начать сравнивать технические характеристики, но все закончилось на первой фразе.

Когда я сказал, что из информационной базы ничего никуда выгружать не надо, человек ответил, что этого достаточно. Потому что в задаче построения дополнительного контура на Power BI ему только на перегрузку данных из одного контура в другой выставили счет в 3 миллиона рублей. Другие работы даже не оценивались. Когда человек понял, что он может на этом сэкономить, он уже радостно побежал в сторону стандартных продуктов фирмы «1С».

Возможности 1С:Аналитики и ключевые отличия от других BI-систем

Обозначу несколько технологических моментов, чем отличается продукт 1С:Аналитика от других решений.

Первое – очень важно, что 1С:Аналитика не выгружает данные из платформы 1С. 1С:Аналитика – это опция внутри платформы, которую вы включаете и получаете вот этот дополнительный красивый интерфейс с возможностью рисовать отчеты и работать в стиле BI

1С:Аналитика – это опция внутри платформы, которую вы включаете и получаете вот этот дополнительный красивый интерфейс с возможностью рисовать отчеты и работать в стиле BI.

Это очень важно, особенно для работы с данными кадрового учета, которые хранятся в 1С:ЗУП КОРП, потому что это вопрос безопасности. Если вы не выгружаете данные из платформы, а работаете с ними постоянно под теми же правами и настройками безопасности, которые уже настроены в вашей конфигурации, вы можете быть уверены, что при работе с этими данными через 1С:Аналитику уровень безопасности будет ровно такой же

Нет никаких рисков, что данные куда-то утекут. Они остаются внутри платформы. И это очень важно

Если вы не выгружаете данные из платформы, а работаете с ними постоянно под теми же правами и настройками безопасности, которые уже настроены в вашей конфигурации, вы можете быть уверены, что при работе с этими данными через 1С:Аналитику уровень безопасности будет ровно такой же. Нет никаких рисков, что данные куда-то утекут. Они остаются внутри платформы

И это очень важно

Второй момент – это то, как 1С:Аналитика работает с данными. Этот инструмент позволяет оперативно посмотреть данные, быстро построить аналитический отчет, покрутить данные в разных разрезах, с разных сторон.

1С:Аналитика позволяет работать с аналитическими отчетами в реальном режиме времени. Вы строите аналитический отчет, и он у вас отрабатывает «на лету» – вы видите результат ровно по тем цифрам, которые лежат у вас в системе. Нет никаких рисков, что данные исказятся. Вы видите ровно то, что в системе – быстро и вот в реальном режиме времени.

1С:Аналитика – это веб-приложение. Вы подключаетесь к ней через браузер, указываете учетные свои данные из конфигурации 1С и начинаете работать.

При этом интерфейс 1С:Аналитики сильно отличается от привычного нам всем «желтого» интерфейса.

Разрабатывая 1С:Аналитику, мы в первую очередь стремились сделать интерфейс интуитивно понятным и максимально простым, не нагруженным теми функциями, которые руководству и большинству бизнес-аналитиков не нужны. Стремились сделать так, чтобы руководство компании и бизнес-аналитики – люди не технического плана – могли быстро освоить этот продукт. Чтобы интерфейс был для них привычен и знаком по тем продуктам класса BI, которые они могли использовать до этого. Здесь интерфейс – это еще один шаг навстречу нашему пользователю.

Лишний раз повторюсь, что 1С:Аналитика – это опция к конфигурации

При этом неважно – типовая конфигурация или нетиповая. Вы разворачиваете 1С:Аналитику и через этот интерфейс начинаете работать с данными

Такой типовой конфигурацией может быть 1С:ЗУП КОРП. Давайте посмотрим реальный пример, как можно анализировать данные в 1С:Аналитике на примере этой типовой конфигурации.

«Микрон»: оптимизация производства и повышение качества продукции

Российский производитель микроэлектроники повысил эффективность калибровочных запусков на своём заводе благодаря big data. Решение, которое разработали в МТС, позволило предприятию на треть снизить время, необходимое для настройки оборудования. Контроль за этим этапом работы очень важен — от него зависит частота сбоев и качество итоговой продукции. Технологический процесс на «Микроне» высокоавтоматизирован и включает сотни однотипных операций, которые генерируют большие массивы данных. Теперь при каждом сбое не приходится заново калибровать всю систему, так как на основе собранных ранее данных можно с высокой точностью определить, какой компонент сработал некорректно.

Внедрение технологичных решений на предприятиях и анализ большого массива данных помогает оптимизировать затраты, работать эффективнее и повышать конкурентоспособность. А вопрос хранения информации удобнее всего решать при помощи облачных технологий.

Перейти в облако

Возможно, вам также будет интересно

В обозримом будущем аккумуляторы или заменяемые батарейки, которые используются для питания бытовой и носимой электроники, могут быть заменены термоэлектрическим генератором, который преобразует тепло человеческого тела в электроэнергию. Расширение рынка электроники обуславливает необходимость постоянной разработки новых способов электропитания устройств, в особенности таких, как портативные нательные сенсоры медицинского назначения.

Существующие в настоящее время термоэлектрические генераторы на основе органических веществ дают такое количество энергии, которого пока еще недостаточно для …

Обеспечение комфортных условий для клиентов и сотрудников компании, а также определенной влажности воздуха при производстве и хранении товара требуют организации эффективной системы увлажнения. Впервые запатентованный в начале XX в. автономный форсуночный увлажнитель воздуха сегодня позволяет регулировать влажность воздуха полностью в автоматическом режиме, нужно лишь один раз настроить систему…

Компания «Эльстер Метроника» представляет новейшую разработку — бытовой однофазный счетчик электроэнергии АЛЬФА СМАРТ AS100 со встроенным модулем Wi-Fi, который позволит поставщикам и потребителям энергоресурсов дистанционно отслеживать детализированную информацию о потреблении электроэнергии.

АЛЬФА СМАРТ AS100 используется как самостоятельный прибор учета, однако наиболее полно его возможности проявляются в составе системы автоматизированного учета электроэнергии (АСКУЭ). В частности, применение нового счетчика позволит соответствующим организациям экономить время и до 40% снижать расходы …